La IA está transformando la ingeniería en casi todos los sectores y áreas de aplicación. Esto conlleva la necesidad de modelos de IA muy precisos. De hecho, los modelos de IA a menudo pueden ser más precisos a medida que sustituyen a los métodos tradicionales, pero a veces esto puede tener un precio: ¿cómo toma decisiones este complejo modelo de IA y cómo podemos, como ingenieros, verificar que los resultados son los esperados?

La IA explicable es un conjunto de herramientas y técnicas que nos ayudan a entender las decisiones de los modelos y a descubrir los problemas de los modelos caja negra, como los sesgos o la susceptibilidad a los ataques de enemigos. La explicabilidad puede ayudar a quienes trabajan en la IA a entender cómo los modelos de aprendizaje automático realizan las predicciones, lo que puede ser tan sencillo como comprender qué características incitan las decisiones del modelo, pero más difícil cuando se trata de explicar modelos complejos.

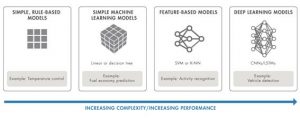

Evolución de los modelos de IA

¿A qué se debe la necesidad de una IA explicable? Los modelos no siempre han sido tan complejos. De hecho, empecemos con el ejemplo simple de un termostato en invierno. El modelo basado en reglas es el siguiente

– Encender la calefacción por debajo de 19 grados

– Apagar la calefacción por encima de 21 grados

¿Funciona el termostato como se espera? Las variables son la temperatura actual de la habitación y si la calefacción está funcionando, por lo que es muy fácil de verificar basándose en la temperatura de la habitación.

Ciertos modelos, como el control de la temperatura, son explicables por sí mismos debido a la simplicidad del problema o a una comprensión inherente y de «sentido común» de las relaciones físicas. En general, para las aplicaciones en las que los modelos de caja negra no son aceptables, el uso de modelos simples que son inherentemente explicables puede funcionar y ser aceptado como válido si son lo suficientemente precisos.

Sin embargo, pasar a modelos más avanzados tiene sus ventajas:

– Precisión: en muchos escenarios, los modelos complejos conducen a resultados más precisos. A veces, los resultados pueden no ser evidentes de inmediato, pero permiten llegar a las respuestas con mayor rapidez.

– Trabajo con datos más sofisticados: Los ingenieros pueden necesitar trabajar con datos complejos como señales en streaming e imágenes que se pueden utilizar directamente en modelos de IA, ahorrando un tiempo significativo en la construcción de modelos.

– Espacios de aplicación complejos: La complejidad de las aplicaciones es cada vez mayor y las nuevas investigaciones están explorando áreas adicionales en las que las técnicas de aprendizaje profundo pueden reemplazar técnicas tradicionales como la extracción de características.

¿Por qué explicabilidad?

A menudo se hace referencia a los modelos de IA como «cajas negras», sin visibilidad de lo que el modelo ha aprendido durante el entrenamiento, o cómo determinar si el modelo funcionará como se espera en condiciones desconocidas. El objetivo de los modelos explicables es hacer preguntas sobre el modelo para descubrir cualquier incógnita y explicar sus predicciones, decisiones y acciones.

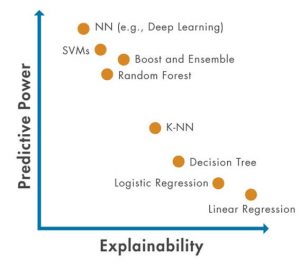

Complejidad frente a explicabilidad

A pesar de todos los aspectos positivos de pasar a modelos más complejos, la capacidad de comprender lo que ocurre dentro del modelo se convierte en un reto cada vez mayor. Por lo tanto, los ingenieros tienen que encontrar nuevos enfoques para asegurarse de que pueden mantener la confianza en los modelos a medida que aumenta la capacidad de predicción.

El uso de modelos explicables puede aportar la máxima información sin añadir pasos adicionales al proceso. Por ejemplo, el uso de árboles de decisión o ponderaciones lineales puede proporcionar pruebas exactas de por qué el modelo eligió un resultado concreto.

Los ingenieros, que necesitan más información sobre sus datos y modelos, están impulsando la investigación de la explicabilidad para:

– Confianza en los modelos: Muchas partes involucradas están interesadas en la capacidad de explicar un modelo en función de su función e interacción con la aplicación. Por ejemplo:

- Un responsable de la toma de decisiones quiere confiar y entender cómo funciona el modelo de IA.

- Un cliente quiere sentirse seguro de que la aplicación funcionará como se espera en todos los escenarios y de que el comportamiento del sistema es racional y relacionable.

- Un desarrollador de modelos desea conocer el comportamiento del modelo y las mejoras que pueden introducirse en la precisión al comprender por qué un modelo toma determinadas decisiones

– Requisitos normativos: Cada vez es mayor el deseo de utilizar modelos de IA en aplicaciones críticas para la seguridad y de gobernanza y cumplimiento que pueden tener requisitos normativos internos y externos. Aunque cada industria tendrá requisitos específicos, proporcionar pruebas de solidez de la formación, imparcialidad y fiabilidad puede ser importante.

– Identificar el sesgo: el sesgo puede introducirse cuando los modelos se entrenan con datos sesgados o con muestras desiguales. El sesgo es especialmente preocupante en los modelos aplicados a personas. Es importante que los desarrolladores de modelos comprendan cómo el sesgo puede influir implícitamente en los resultados y lo tengan en cuenta para que los modelos de IA «generalicen», es decir, proporcionen predicciones precisas sin favorecer implícitamente a grupos y subconjuntos.

– Depuración de modelos: Para los ingenieros que trabajan con modelos, la explicabilidad puede ayudar a analizar predicciones incorrectas del modelo. Esto puede incluir la búsqueda de problemas en el modelo o en los datos. En la siguiente sección se describen algunas técnicas específicas de explicabilidad que pueden ayudar en la depuración.

Métodos Explicables Actuales

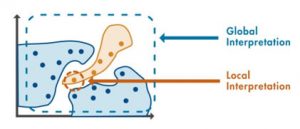

Los métodos de explicabilidad se dividen en dos categorías:

– Los métodos globales proporcionan una visión general de las variables más influyentes en el modelo basándose en los datos de entrada y el resultado predicho.

– Los métodos locales proporcionan una explicación de un único resultado de predicción.

Comprender la influencia de las características

Los métodos globales incluyen la clasificación de características, que ordena las características por su impacto en las predicciones del modelo, y los gráficos de dependencia parcial, que se centran en una característica específica e indican su impacto en las predicciones del modelo en todo el rango de sus valores.

Los métodos locales más populares son:

- LIME para aprendizaje automático y profundo: Local Interpretable, Model-agnostic Explanation (LIME) puede utilizarse tanto en el aprendizaje automático tradicional como en la depuración de redes neuronales profundas. La idea es aproximar un modelo complejo con un modelo simple y explicable en las proximidades de un punto de interés, y así determinar cuál de los predictores influyó más en la decisión.

- Valores de Shapely: El valor de Shapley de una característica para un punto de consulta explica la desviación de la predicción respecto a la predicción media, debida a la característica. Utilice los valores de Shapley para explicar la contribución de las características individuales a una predicción en el punto de consulta especificado.

Visualizaciones

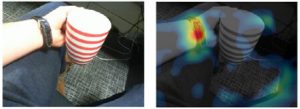

Cuando se construyen modelos para aplicaciones de procesamiento de imágenes o visión por ordenador, las visualizaciones son una de las mejores formas de evaluar la explicabilidad del modelo.

– Visualizaciones de modelos: Los métodos locales como Grad-CAM y la sensibilidad a la oclusión pueden identificar los lugares de las imágenes y el texto que más han influido en la predicción del modelo

– Comparaciones y agrupaciones de características: El método global T-SNE es un ejemplo del uso de agrupaciones de características para comprender las relaciones entre categorías. El método T-SNE es muy útil para mostrar datos de alta dimensionalidad en un simple gráfico bidimensional.

Éstas son sólo algunas de las muchas técnicas disponibles en la actualidad para ayudar a los desarrolladores de modelos con la explicabilidad. Independientemente de los detalles del algoritmo, el objetivo es el mismo: ayudar a los ingenieros a comprender mejor los datos y el modelo. Cuando se utilizan durante el modelado y las pruebas de IA, estas técnicas pueden proporcionar más información y confianza en las predicciones de IA.

Más allá de la Explicabilidad

La explicabilidad ayuda a superar un importante inconveniente de muchos modelos avanzados de IA y su naturaleza de caja negra. Pero superar la resistencia de las partes interesadas o de los organismos reguladores a los modelos de caja negra es sólo un paso hacia el uso seguro de la IA en los sistemas de ingeniería. La IA utilizada en la práctica requiere modelos comprensibles, construidos mediante un proceso riguroso y capaces de funcionar al nivel necesario para aplicaciones sensibles y críticas desde el punto de vista de la seguridad.

Entre las áreas de interés y mejora se incluyen las siguientes

– Verificación y validación: Un área de investigación en curso es V&V, que lleva la explicabilidad más allá de la confianza y la prueba de que un modelo funciona en determinadas condiciones, sino que se centra en los modelos utilizados en aplicaciones críticas para la seguridad que deben cumplir unas normas mínimas.

– Certificación de seguridad: Industrias como la automovilística y la aeroespacial están definiendo cómo debe ser la certificación de seguridad de la IA para sus aplicaciones. Los enfoques tradicionales sustituidos o mejorados con IA deben cumplir las mismas normas y sólo tendrán éxito si se prueban los resultados y se muestran resultados interpretables.

– Modelos más transparentes: El resultado del sistema debe coincidir con las expectativas de la persona. Es algo que un ingeniero debe plantearse desde el principio: ¿cómo compartiré mis resultados con el usuario final?

¿Es la Explicabilidad aecuada para su aplicación?

El futuro de la IA hará especial hincapié en la explicabilidad. A medida que la IA se incorpore a aplicaciones cotidianas y críticas para la seguridad, es probable que aumente la investigación tanto de las partes interesadas internas como de los usuarios externos. Considerar la explicabilidad como algo esencial beneficia a todos. Los ingenieros disponen de mejor información para depurar sus modelos y asegurarse de que el resultado coincide con su intuición. Obtienen más información para cumplir los requisitos y las normas. Y pueden centrarse en aumentar la transparencia de unos sistemas cada vez más complejos.

Para más información, pinche aquí.